Deutsche Börse testet Quantum Computing erfolgreich im Risk-Management

Vectorfusionart / Bigstockphoto

Die Berechnung von Risiko-Modellen auf regulärer Hardware schränkt die Zahl der Eingabe-Parameter ein – denn je mehr Variablen umso länger die Rechenzeit. Ein Pilotprojekt der Deutschen Börse mit dem FinTech JoS Quantum hat nun gezeigt, dass Quantum Computing solche Anwendungen extrem beschleunigt. Doch die Marktreife lässt noch Jahre auf sich warten.

Der Einsatz von Quanten-Computern könnte sich vom theoretischen Konzept zur nächsten bahnbrechenden Technologie in der Finanzbranche entwickeln. Sie verspricht die Lösung von bislang unlösbaren Problemen. Dementsprechend hoch ist der Druck im Rennen um die „Quantenvorherrschaft“ , wirtschaftliche Anwendungen zu erschließen, die mit herkömmlicher IT schlichtweg nicht zu erreichen sind.Auch die Gruppe Deutsche Börse beobachtet neue Trends und Treiber der Branche und testet diese auf Anwendungstauglichkeit, darunter auch die Quanten-Technologie. Sie beauftragte im Rahmen eines Pilotprojekts das Frankfurter FinTech JoS QUANTUM mit der Entwicklung eines Quantenalgorithmus. Im Rahmen des Projektes sollten Lösungen für die bestehenden Herausforderungen bei der Berechnung von Geschäftsrisikomodellen gefunden werden. Zudem sollte das generelle Verständnis für das Quantum Computing verbessert werden.

Risiken durch externe Einflüsse abbilden

Die Risikomodelle der Deutschen Börse sollen die finanziellen Auswirkungen prognostizieren, die sich beispielsweise durch makroökonomische Ereignisse, Veränderungen im Wettbewerb oder neue regulatorische Rahmenbedingungen ergeben. Bislang erfolgt die Berechnung mit Hilfe klassischer Monte-Carlo-Simulationen auf vorhandener Standard-Hardware.

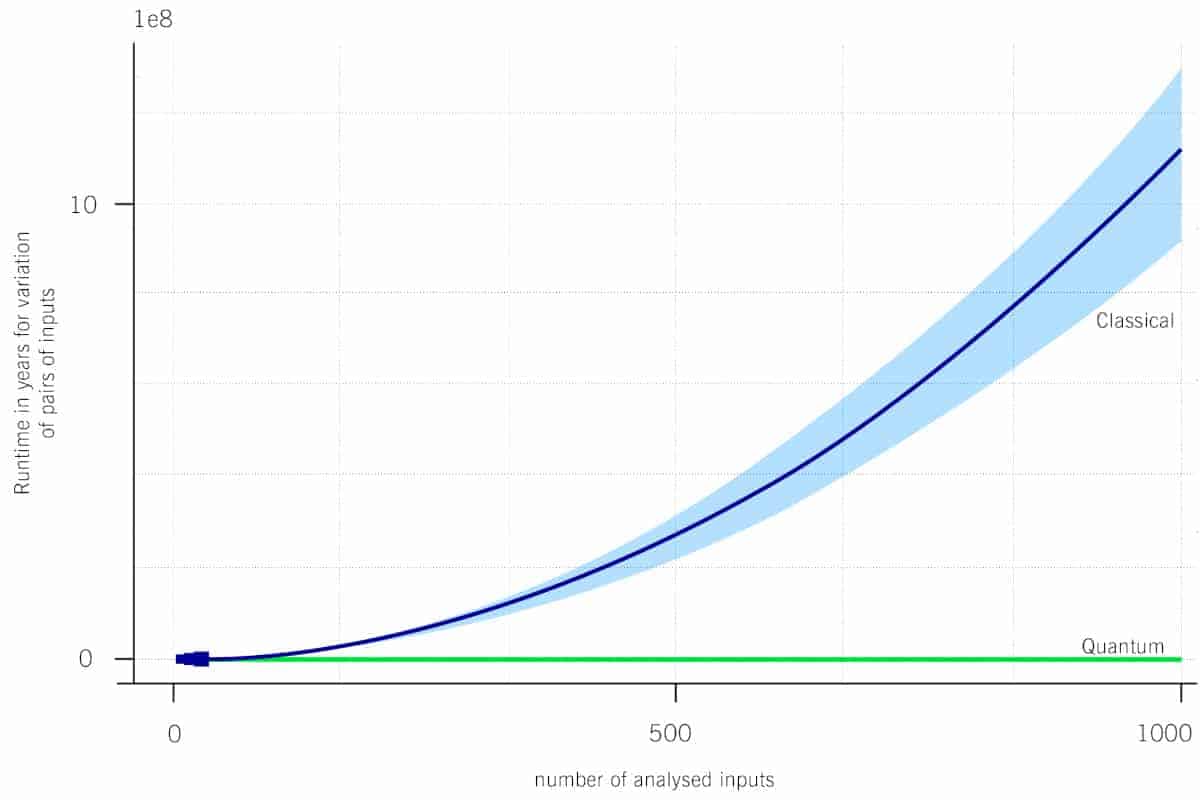

Das Problem: Je besser die Risiko-Abschätzung sein soll, um so mehr Simulationsparameter müssen berücksichtigt werden und um so komplexer muss das Berechnungsmodell sein. Doch damit erhöht sich die Laufzeit der Berechnung exponentiell: in der Praxis von einigen Minuten bis hin zu Stunden oder gar mehreren Tagen. Die Berücksichtigung von 1.000 Parametern würde die Berechnungszeit auf Basis derzeit verfügbarer IT-Infrastruktur auf mehr als 10 Jahre hochschrauben – damit ginge jeder wirtschaftliche Nutzen verloren.

JoS Quantum

Warp-Faktor 200.000

Um die Praxistauglichkeit der Quanten-Technologie abzuschätzen wurde in einem ersten Schritt die zu erwartende Reduzierung der Rechenzeit anhand eines vereinfachten Modells simuliert. Die Kombination von Amplitudenschätzung, der Quantenversion der Monte-Carlo-Simulation, mit dem Grover-Algorithmus, einem Quantensuchalgorithmus, zeigte eine quadratische Beschleunigung und ermöglichte so einen ersten Vergleich mit dem Rechenaufwand der traditionellem Monte-Carlo-Simulation.

In einem zweiten Schritt wurden die Resultate des vereinfachten Modells auf eine praxisrelevante Modellgröße extrapoliert. Es zeigt sich, dass die Anwendung von Quantum Computing den erforderlichen Rechenaufwand und damit die Gesamtberechnungszeit drastisch reduzieren würde. Für die gewählte Benchmark von 1.000 Eingaben beträgt der „Warp-Faktor“ etwa 200.000, was die handelsübliche Monte-Carlo-Rechenzeit von etwa 10 Jahren auf weniger als 30 Minuten Quantum Computing-Zeit reduzieren würde.

Der dritte Schritt war ein Praxistest auf der IBM Quantenmaschine „Vigo“, die sich in Poughkeepsie im US-Bundesstaat New York befindet. Der Zugriff erfolgte über die IBM-Cloud. Aufgrund der begrenzten Zahl der Qubits musste die Modellgröße begrenzt werden. Trotzdem war es auf diese Weise möglich, die Implementierung des Risikomodells in Quantencode zu verifizieren.

Außerdem wurden die Hardware-Anforderungen für die jeweilige Anzahl und Qualität der Qubits evaluiert, um abzuschätzen, welche Generation von Quantencomputer-Hardware für eine vollständige Sensitivitätsanalyse in der Produktion benötigt werden wird. Es ist absehbar, dass diese bereits in einigen Jahren verfügbar sein wird.

Positives Fazit

Für die Deutsche Börse wurden die wichtigsten Ziele erreicht. Zum einen konnte ein verkürztes Risikomodell erfolgreich auf einer IBM-Quantenmaschine ausgeführt werden. Die benötigte Quanten-Hardware, die für eine vollständige Modellberechnung benötigt wird, dürfte in der zweiten Hälfte des laufenden Jahrzehnts zur Verfügung stehen. Die reale Anwendung von Quantum Computing im Risikomanagement könnte daher nur noch eine Frage weniger Jahre sein.

Dann wird ein ausgefeiltes, detailliertes und schnelles, aber auch robustes Risikomanagementmodell möglich, das umfassende Sensitivitätsanalysen liefert. Die Anwendung zeigt darüber hinaus Potenzial für weitere Bereiche. Die Quantenexperten der Deutschen Börse nennen hier beispielsweise komplexere Modelle bei Kreditrisiken und operationelle Risiken, die zu genaueren Vorhersagen führen.

Neben der Förderung der FinTech-Szene soll das Projekt auch dem wissenschaftlichen Fortschritt dienen. Die Details sind daher in der wissenschaftlichen Arbeit „A Quantum Algorithm for the Sensitivity Analysis of Business Risks“ dokumentiert, die hier zum kostenlosen Download bereitsteht. hj

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/118472

[/speaker-mute]

Schreiben Sie einen Kommentar