Vorsprung durch Datenqualität: Business Intelligence und Analytics für die Finanzwirtschaft

Unternehmen aus der Finanzbranche können in hohem Maße von der Implementierung von Business Intelligence (BI)-Lösungen profitieren. Dabei bringt die Technologie nicht nur Vorteile für einige wenige, sondern für Anwender aus den unterschiedlichsten Abteilungen und Unternehmensebenen mit sich. So lassen sich mit modernen Analysemethoden beispielsweise zuverlässigere Prognosen erstellen, die oft den entscheidenden Vorteil im Wettbewerb ausmachen können. Doch auch für den Kundenservice und das Aufdecken oder das frühzeitige Erkennen von Betrugsversuchen, bringt der Umstieg auf eine moderne BI-Lösung einen signifikanten Mehrwert.

von Nathan Jagoda, Information Builders

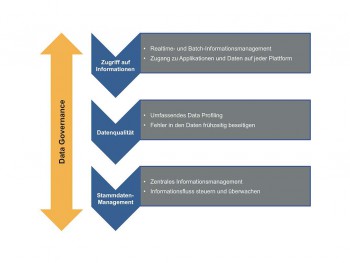

Die Grundlage einer erfolgreichen BI-Strategie ist immer die Qualität der Daten. So wirkt sich mangelhafte Datenqualität beispielsweise auf die Datenintegration aus, und kann einen erhöhten Prozessaufwand bewirken. Sogar direkte finanzielle Auswirkungen sind möglich, wenn fehlerhafte Daten als Grundlage für Risikokalkulationen, zur Einschätzungen der Kundenwünsche oder als Basis für die Entwicklung neuer Produkte dienen. Die gute Nachricht: Durch ein systematisches Vorgehen lässt sich die Datenqualität steigern – wenn Fachabteilungen und IT eng zusammenarbeiten. Die vier wichtigsten Bausteine für eine bessere Datenqualität sind eine Analyse der Informationszugriffe, Metriken zur Bewertung der Datenqualität, Stammdaten-Management und Data Governance.

Analyse der Informationszugriffe

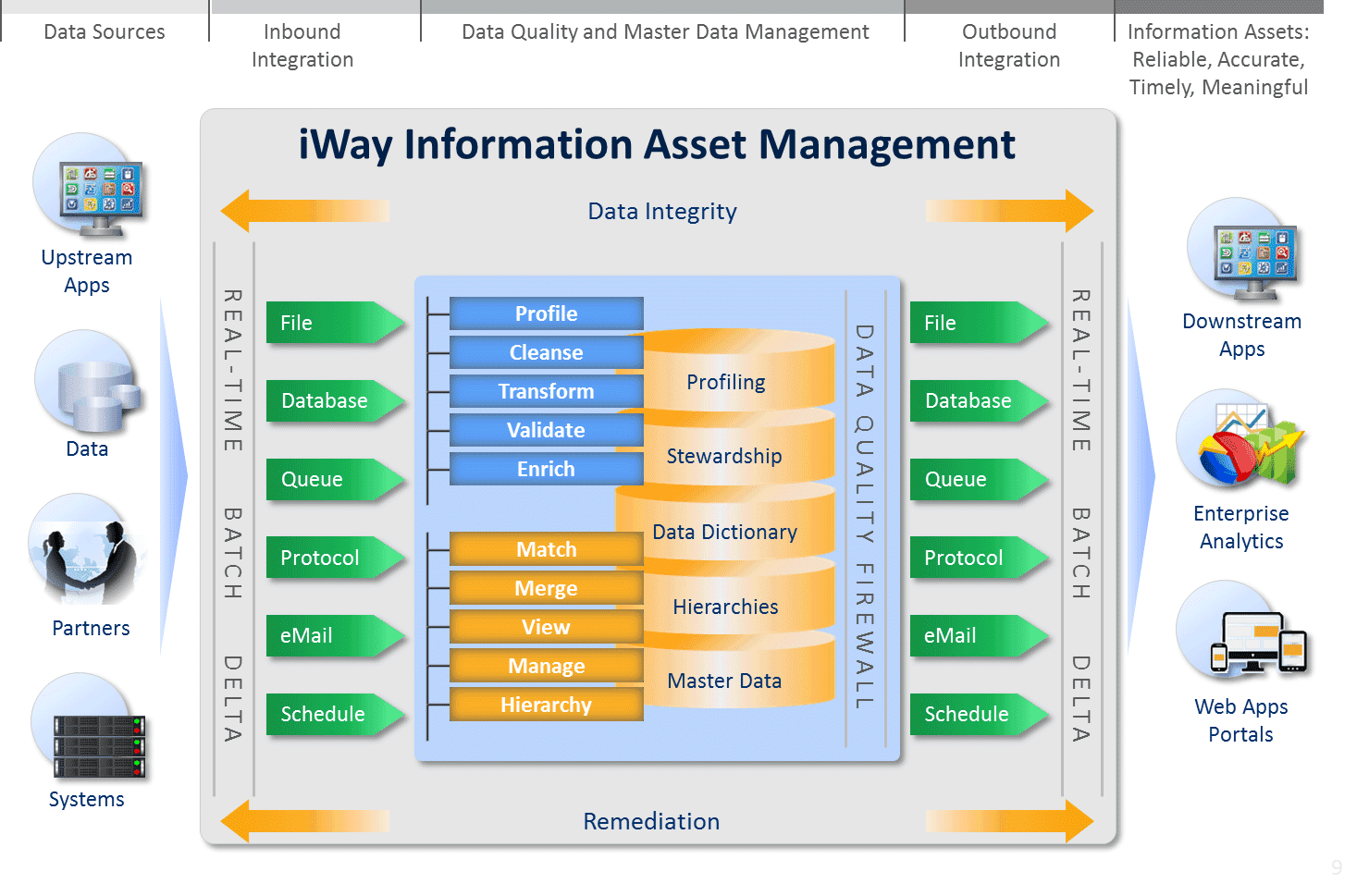

Um eine stabile Grundlage für eine hinreichende Datenqualität zu schaffen, ist es wichtig zu untersuchen, woher die Daten stammen und was mit ihnen geschieht. Entscheidend ist hier nicht nur, in welchen Bereichen des Unternehmens Anwender und Applikationen Daten erzeugen. Ebenso wichtig ist, wer von welchem Ort im Unternehmen auf die Daten zugreift, sie bearbeitet, aktualisiert oder löscht. Neben der Sicherung der Datenqualität können auf diesem Weg bereits erste Muster erkannt werden, die später zu einer effizienteren Organisation der Prozesse herangezogen werden können.

Gibt es beispielsweise unnötige Schleifen bei der Bearbeitung von Daten, können diese abgekürzt werden. Wird hingegen ein wichtiger Schritt bei der Datenverarbeitung übergangen oder laufen sogar Prozesse ins Leere, kann interveniert werden. Dies geschieht idealerweise nach dem Subsidiaritätsprinzip zu einem möglichst frühen Zeitpunkt in den Fachabteilungen. So wird sichergestellt, dass die Daten korrekt, konsistent, eindeutig und zuverlässig sind. Nur Daten, die diesen Anforderungen entsprechen, werden im internen Informationspool bereitgestellt, aus dem später die Daten beispielsweise für die Risikokalkulation und andere Entscheidungsgrundlagen gezogen werden.

Metriken zur Bewertung der Datenqualität

Selbst wenn alle Abläufe optimiert sind, ist eine ständige Überprüfung der Daten ein grundlegender Faktor, um die Datenqualität dauerhaft stabil auf einem hohen Niveau zu halten. Hierfür sollten Versicherer und andere Unternehmen individuell angepasste Metriken und Standards zur Bewertung ihrer Datenqualität entwickeln.

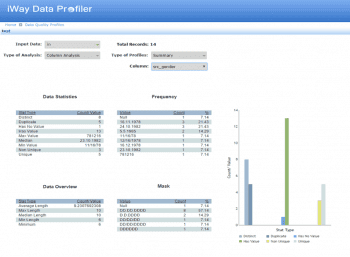

Ziel ist es, Auswertungen zum Einsatz von Unternehmensdaten zu erstellen: Welche Benutzer greifen am häufigsten auf welche Daten zu, für welche Zwecke und in welchen Anwendungsszenarien werden die Daten eingesetzt. Zusätzlich helfen Data-Profiling-Tools, mithilfe von Geschäftsregeln, die Aktualität oder die Vollständigkeit und damit den Status der Daten einzuschätzen, Fehler zu ermitteln, zu priorisieren, zu korrigieren und die Ursachen von Qualitätsproblemen zu beheben. Sind erst einmal Datenprofile der Bewegungs- und Stammdaten erstellt, kann durch die laufende Überwachung profilbezogener Parameter schneller auf Qualitätsprobleme reagiert werden.

Stammdaten-Management:

Ist H. Schmidt, Hans Schmidt, Hans H. Schmidt und Dr. Hans Schmidt derselbe?

Ein effizientes, durchdachtes Stammdaten-Management ist eine wichtige Grundlage für die Datenqualität, die einem Unternehmen – gleich aus welcher Branche – zur Verfügung steht. Je besser die Stammdaten gepflegt werden, desto wertvoller sind sie für das Unternehmen. Tools für das Stammdaten-Management haben die Aufgabe, die Herausforderungen rund um die „Single Version of the Truth“ zu lösen: Betreffen beispielsweise Verträge, die über einen längeren Zeitraum abgeschlossen wurden und auf die Namen H. Schmidt, Hans Schmidt, Hans H. Schmidt und Dr. Hans Schmidt laufen dieselbe Person oder handelt es sich um mehrere Personen? Tools für das Stammdaten-Management sollten über Funktionen für Validierung und Identitätsmanagement, Integration sowie Konsolidierung verfügen. Für spezielle Aufgaben bieten sich Lösungen an, die gezielt für Versicherungen, Banken oder Finanzdienstleister entwickelt wurden und genau ihren Anforderungen entsprechen.

Die Bedeutung von Stammdaten ist den meisten Unternehmen durchaus bewusst. Leider werden sie dennoch oft nicht effizient genutzt und gepflegt. Vielmehr lässt sich häufig ein Duplizieren beobachten, das in seiner letzten Konsequenz zu einem unübersichtlichen Datenwust führt,, der Entscheidungen verlangsamt, blockiert oder sogar in die falsche Richtung lenkt. Das Stammdaten-Management sollte daher unbedingt harmonisch und einheitlich organisiert und über unternehmensweit bindende Leitlinien geregelt sein.

Data Governance

Besonders, wenn Informationen aus verschiedenen Quellen zusammengeführt werden, die in den Metadaten nicht sauber beschrieben sind, erhöht sich die Komplexität um ein Vielfaches. Der Schlüssel ist eine funktionstüchtige Data Governance. Dadurch erhält die IT eine zentrale Kontrollmöglichkeit und Analysten die nötige Flexibilität. Mit der Data Governance werden dabei die übergeordneten Anforderungen für Datenqualität und Stammdaten-Management fixiert. Dies ist besonders in Branchen, die mit sensiblen Daten arbeiten, wie der Finanz- oder Versicherungsbranche, von zentraler Bedeutung. Hier legen Unternehmen fest, wie mit Rohdaten und aufbereiteten Informationen zu verfahren ist, für welche Daten welche Sicherheitsanforderungen und Compliance-Auflagen berücksichtigt werden müssen und welche Gruppen von Mitarbeitern auf welche Daten zugreifen können. Datenqualitäts- und Stammdaten-Management lassen sich jedoch nicht mit einem einmaligen Projekt erledigen. Sie müssen vielmehr einem Kreislaufmodell folgen, das auf eine kontinuierliche Verbesserung ausgerichtet ist. Darüber hinaus sollte sich das Konzept der Data Governance in der Unternehmenskultur widerspiegeln, um eine maximale Rendite aus der Investition in BI- und Analyselösungen zu ziehen. Denn von einer besseren Datenqualität profitieren unter dem Strich alle umsatzrelevanten Workflows und Geschäftsprozesse.

Die Basis muss stimmen

Bei der Umsetzung einer BI-Strategie ist es wichtig, von Beginn an für eine hohe Datenqualität zu sorgen. Die inhaltlichen Vorgaben für die Implementierung einer Datenqualitätsstrategie liefern die Fachabteilungen, die technologische Grundlage für eine gleichbleibend hohe Datenqualität muss die IT sicherstellen. Für diese besteht die Herausforderungen darin, die Informationen aus unterschiedlichen Datenquellen zu vereinheitlichen und konsistent zu halten. Die fachlich-inhaltliche und organisatorische Koordination zwischen der IT und den Fachbereichen sollte ein Data Steward übernehmen, der für die Unternehmensdaten verantwortlich ist. Je nach Unternehmensgröße kann es sich dabei auch um ein Team oder eine eigene Abteilung handeln. Um eine maximale Rendite aus den Investitionen in BI- und Analyselösungen zu ziehen, ist es außerdem wichtig, dass sich das Konzept der Data Governance in der Unternehmenskultur widerspiegelt. Eine hohe Datenqualität ist ein entscheidender Faktor, wenn es darum geht, das Potential der unternehmenseigenen Daten voll auszuschöpfen, Innovationen zu entwickeln und das Unternehmen langfristig auf Erfolgskurs zu halten.aj

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/9677

Schreiben Sie einen Kommentar