Operationelle Risiken quantifizieren:

Darauf sollten Banken bei der IT-Umsetzung achten

Dr. Peter & Company

Seit Jahren beißen sich Banken und Versicherer die Zähne aus, wie sie operationelle Risiken adäquat modellieren können. Die Aufgabe bleibt aktuell. Viele Finanzdienstleister suchen immer noch nach einer optimalen Vorgehensweise, um fachliche Quantifizierungsmodelle und technische Umsetzung zu vereinen. Das hat Gründe: Operationelle Risiken, beispielsweise unpräzise Anlageberatung, IT-Risiken und Betrugsfälle, sind sehr individuell. PPI und Dr. Peter und Company fassen für IT Finanzmagazin ihr gemeinsames Whitepaper zusammen – und klären, worauf Institute bei der Konzeption und Umsetzung von IT-Lösungen achten sollten.

von Dr. Michael Herbst, PPI und

Christof Born, Dr. Peter & Company

PPI

Die Finanzaufsicht unterteilt operationelle Risiken in sieben Ereigniskategorien:

1. interner Betrug2. externer Betrug

3. Beschäftigungspraxis und Arbeitsplatzsicherheit

4. Kunden, Produkte und Geschäftsgepflogenheiten

5. Sachschäden

6. Geschäftsunterbrechungen und Systemausfälle

7. Ausführung, Lieferung und Prozessmanagement

Das zeigt, wie vielfältig operationelle Risiken ausfallen können. Sie reichen von Naturgewalten und Unfällen über Beratungsfehler bis zum IT-Ausfall im Rechenzentrum. Dadurch wird die Messung und Aggregation zu einer Gesamtrisikoposition zu einer äußerst komplexen Angelegenheit. Rechenmethoden und Datentöpfe müssen sich zudem einfach und flexibel anpassen lassen. Denn die Vorgaben der Aufsichtsinstanzen und die äußeren Bedingungen ändern sich deutlich schneller als zum Beispiel bei der Risikoart „Kreditrisiko“ – beispielsweise bei IT-Risiken durch technologische Weiterentwicklungen.

Technische Umsetzung bereits bei fachlicher Konzeption mitdenken

Die extreme Anforderung an die Beweglichkeit der Rechenmodelle lässt sich mit Standardsoftware allein nur schwer umsetzen. Viele Institute weichen deshalb auf teure und zum Teil schwerfällige Eigenentwicklungen aus. Doch es geht auch effizienter: Mit einem Plus an Professionalisierung bei der Verzahnung der Fachseite mit der IT können Banken und Versicherungen verschiedene IT-Typen einsetzen und arbeiten damit deutlich effizienter als mit einer reinen Ausrichtung auf Standardlösungen oder Eigenentwicklungen.

Bereits bei der Konzeption eines fachlichen Modells empfiehlt es sich, darauf zu schauen, welche IT-Instrumente den besten Mix aus Qualität und Effizienz bieten. Eine klassische Modell-Konzeption umfasst dabei vier Schritte:

1. Bestimmung und Aufbereitung der Datenbasis2. Auswahl und Anpassung mathematischer Verteilungen

3. Faltung der Verteilungspaare (Häufigkeit und Höhe) zu Verlustverteilungen in Monte-Carlo-Simulation

4. Aggregation zur Gesamtsicht

Jeder dieser vier Schritte stellt unterschiedliche Anforderungen an eine Softwarelösung.

PPI, Dr. Peter & Company

1. Aufbereitung der Datenbasis

Um operationelle Risiken zu bestimmen, müssen Banken verschiedene Daten verknüpfen, die aus einer Vielzahl von Quellen stammen – beispielsweise der zentralen Schadensfall-Datenbank des Instituts sowie externe Schadensfälle. Eine Softwarelösung, die ohne große Handgriffe viele Datenquellen einbindet und eine große Bandbreite an Datenformaten erlaubt, minimiert den administrativen Aufwand. Das ist meistens ein Fall für klassische BI-Produktlösungen. Ein passendes Framework ist Base SAS. Mit der Lösung lassen sich interne und externe Verlust- und Schadensdaten zu einem gemeinsamen Ausgangsdatenset kombinieren.

2. Auswahl der Verteilungsfunktionen

Schadenshäufigkeit und -höhe werden in mathematischen Verteilungen dargestellt. Für eine flexible Auswahl der Funktionen bieten sich Softwarelösungen an, in denen bereits viele Verteilungen implementiert sind und die sich einfach um weitere Verteilungsklassen ergänzen lassen. Optimalerweise kann kurzfristig auf aktuelle Entwicklungen aus der Statistik zugegriffen werden. So können zum Beispiel Fat-Tail-Verteilungen oder Verteilungen aus der Extremwerttheorie einfach eingebunden werden. Bei diesem Schritt sind Eigenentwicklungen im Vorteil. Der Fachbereich kann so sein spezifisches Know-how und individuelle Anforderungen berücksichtigen.

3. Simulation im Rechenkern

Die Simulation der Verteilungen zu Verlustverteilungen ist der rechenintensivste Schritt. Hier sind Softwarelösungen gefordert, bei denen Rechenprozesse einfach parallelisiert werden können. Der Parallellauf bedeutet eine Zeitersparnis bei der Modellierung der Risiken, die Verwendung mehrerer Rechen- oder Grafikprozessoren spart technische Infrastruktur. Beispielsweise bringt das Programmier-Framework Open Source R diese Technologien bereits mit. Damit lassen sich die unterschiedlichen Ansätze für die Implementierung der Simulation und zur Parallelisierung direkt evaluieren.

4. Aggregation und Kennzahlenermittlung

Im letzten Schritt der Modellierung müssen die Ergebnisse aus der Simulation zu einer transparenten Gesamtsicht zusammengefasst werden. Im Ergebnis wollen Institute klassische Kennzahlen für das OpRisk-Management ableiten – beispielsweise den Value-at-Risk (VaR). Bei diesem Schritt ist eine benutzerfreundliche Analysesoftware gefragt. Idealerweise lassen sich die Ergebnisse grafisch und tabellarisch darstellen. Zudem sollte ein Vergleich mit den Ergebnissen aus Vorperioden auf einen Blick möglich sein. Mit Base SAS lassen sich aus den Simulationsergebnissen Reports für unterschiedliche Adressatenkreise erstellen. Die Verteilung und der Zugriff erfolgen beispielsweise automatisch über ein Web-Portal.

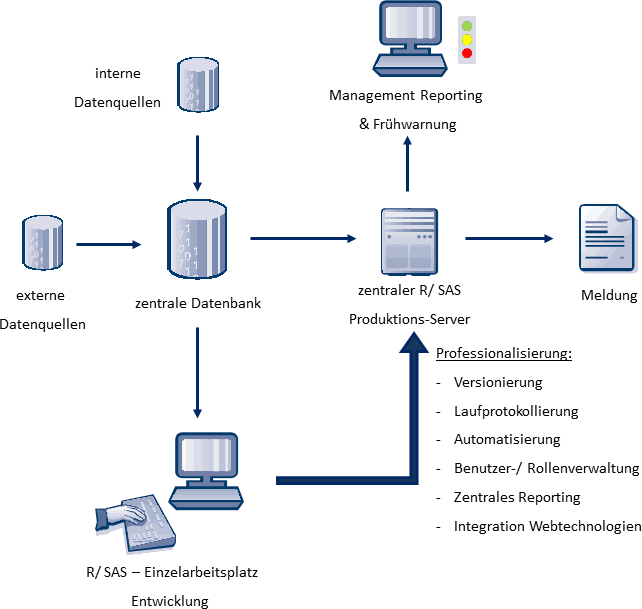

Professionelle Umgebung sichert den Mehrwert agiler IT

Flexible technische Lösungen entfalten ihre volle Wirkung dann, wenn sie in einen professionellen Rahmen eingebettet sind. Und hier können Finanzinstitute häufig noch zulegen. Viele Datenanalysten und Entwickler im Fachbereich arbeiten mit Installationen auf Arbeitsplatzrechnern, oder sie nutzen eigene User-Verzeichnisse auf Base-SAS-Servern. In der Folge werden notwendige Weiterentwicklungen von Modellen und Methoden häufig lokal programmiert. Das gleiche gilt insbesondere für die Erstellung von Ad-hoc-Reportings bei kurzfristigen Anfragen durch Vorstände oder die Finanzaufsicht.

Dadurch wird viel manuell entwickelt und autark gearbeitet. Es fehlt die Automatisierung und eine zentrale Verwaltung. Reportingergebnisse lassen sich damit nicht immer einwandfrei oder nur mit viel Aufwand rekonstruieren, wenn beispielsweise eine Prüfung durch die Finanzaufsicht ansteht.

Professionell integrierte Umgebungen zeichnen sich dagegen dadurch aus, dass sich Ergebnisse effizient und revisionssicher erstellen und nachvollziehen lassen. Dazu gehören unter anderem die Versionierung von Quellcode oder die Historisierung von Ausgangsdaten, der Laufausführung und der Ergebnisse sowie eine adäquate Benutzer- und Rollenverwaltung.

Revisionssicherheit und Prüfungsfähigkeit der implementierten IT-Lösung sind für Banken und Versicherungen Pflicht. Darüber hinaus spielt die Anwenderfreundlichkeit der grafischen Benutzeroberfläche eine entscheidende Rolle für den operativen Betrieb. Die Software darf nicht als Black Box im Unternehmen positioniert werden. Ausgewählte Mitarbeiter müssen die Umsetzung der fachlichen Modellbestandteile im Quellcode nachvollziehen und im Einzelfall anpassen können.

Banken und Versicherer profitieren von einem weiteren Professionalisierungsschritt im Risikomanagement. Die Analyseplattform lässt sich zu einer voll integrierten Reporting-Plattform weiterentwickeln. Diese kann bereichsübergreifend genutzt werden, bildet die Risikostruktur eines Unternehmens auf verschiedenen Ebenen ab und lässt sich zu einem wirksamen Frühwarnsystem ausbauen.

Das dem Beitrag zugrunde liegende Whitepaper „Quantifizierung operationeller Risiken: Modellkonzeption und Implementierung“ ist kostenlos als Download von den Webseiten der PPI und Dr. Peter & Company erhältlich.aj

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/27426

Schreiben Sie einen Kommentar